Código e Automação

15 de dez. de 2025

Go back

Automatizar extração de e-mails com Python: de scripts locais ao Apify

Aprenda como automatizar a extração de e-mails com Python e conheça a versão escalável do projeto via Apify, com exportação automática em CSV.

Fique por dentro do que há de mais relavante no Marketing Digital, assine a nossa newsletter:

Introdução

Automatizar a extração de e-mails é uma necessidade recorrente em projetos de prospecção, pesquisa, mapeamento institucional e inteligência de dados, especialmente quando falamos de ONGs, associações, empresas e iniciativas públicas.

Este artigo nasceu a partir de um script em Python voltado à extração de e-mails a partir de fontes como Google Maps e páginas públicas. Com o tempo, o projeto evoluiu — tanto tecnicamente quanto em escopo — até se tornar uma ferramenta escalável, sem código e pronta para uso, publicada como um Actor no Apify.

Neste conteúdo, você vai entender:

Como funciona a extração automatizada de e-mails com Python

As limitações de scripts locais

Como transformar um script em um produto escalável

Quando faz sentido usar código e quando usar uma solução pronta

Nota importante sobre o escopo do artigo

⚠️ Sobre o slug deste post

O slug deste artigo menciona Google Maps porque a primeira versão do projeto foi concebida para demonstrar a extração automatizada de e-mails a partir de dados públicos encontrados em plataformas como o Google Maps.

Com a evolução do projeto, a mesma base técnica passou a ser aplicada de forma mais ampla, permitindo a extração de e-mails diretamente de sites institucionais, ONGs, empresas e portais, hoje disponível como um Actor no Apify.

O foco atual é extração de e-mails a partir de websites e seus links internos, mantendo apenas o contexto histórico do desenvolvimento inicial.

O problema da extração manual de e-mails

Em muitos projetos, a coleta de e-mails ainda acontece de forma manual:

Copiar e colar informações de páginas “Contato”

Navegar por dezenas de links internos

Consolidar dados manualmente em planilhas

Lidar com duplicações e erros humanos

Esse processo:

Não escala

Consome tempo operacional

Gera bases inconsistentes

Não é sustentável em projetos recorrentes

Automação deixa de ser luxo e passa a ser infraestrutura.

A abordagem inicial: extração de e-mails com Python

A primeira versão deste projeto foi desenvolvida como um script local em Python, explorando conceitos clássicos de web scraping:

Requisições HTTP (requests)

Parsing de HTML (BeautifulSoup)

Expressões regulares para identificação de e-mails

Normalização e deduplicação de dados

Geração de CSV local

Essa abordagem funciona muito bem para:

Aprendizado técnico

Provas de conceito (POC)

Projetos pontuais

Ambientes controlados

Além disso, fontes como Google Maps e páginas institucionais frequentemente expõem e-mails públicos que podem ser coletados legalmente para fins de pesquisa e contato institucional.

Limitações de scripts locais

Apesar de eficientes, scripts locais apresentam limitações claras quando o projeto cresce:

Dependem de ambiente técnico configurado

Não são acessíveis a usuários não técnicos

Não possuem interface visual

Exigem execução manual

Exportação e organização de dados ficam por conta do usuário

Não escalam bem para equipes ou clientes

Foi exatamente esse cenário que motivou a evolução do projeto.

A evolução: de script em Python para Actor no Apify

Para resolver os problemas de escala, usabilidade e distribuição, o projeto foi transformado em um Actor no Apify, mantendo a lógica técnica, mas adicionando uma camada de produto.

O que muda com o Apify

Interface visual para entrada de URLs

Execução em nuvem

Dataset estruturado

Exportação automática em CSV ou JSON

Deduplicação automática

Sem necessidade de escrever código

Uso sob demanda (pay per result)

👉 Versão pronta para uso

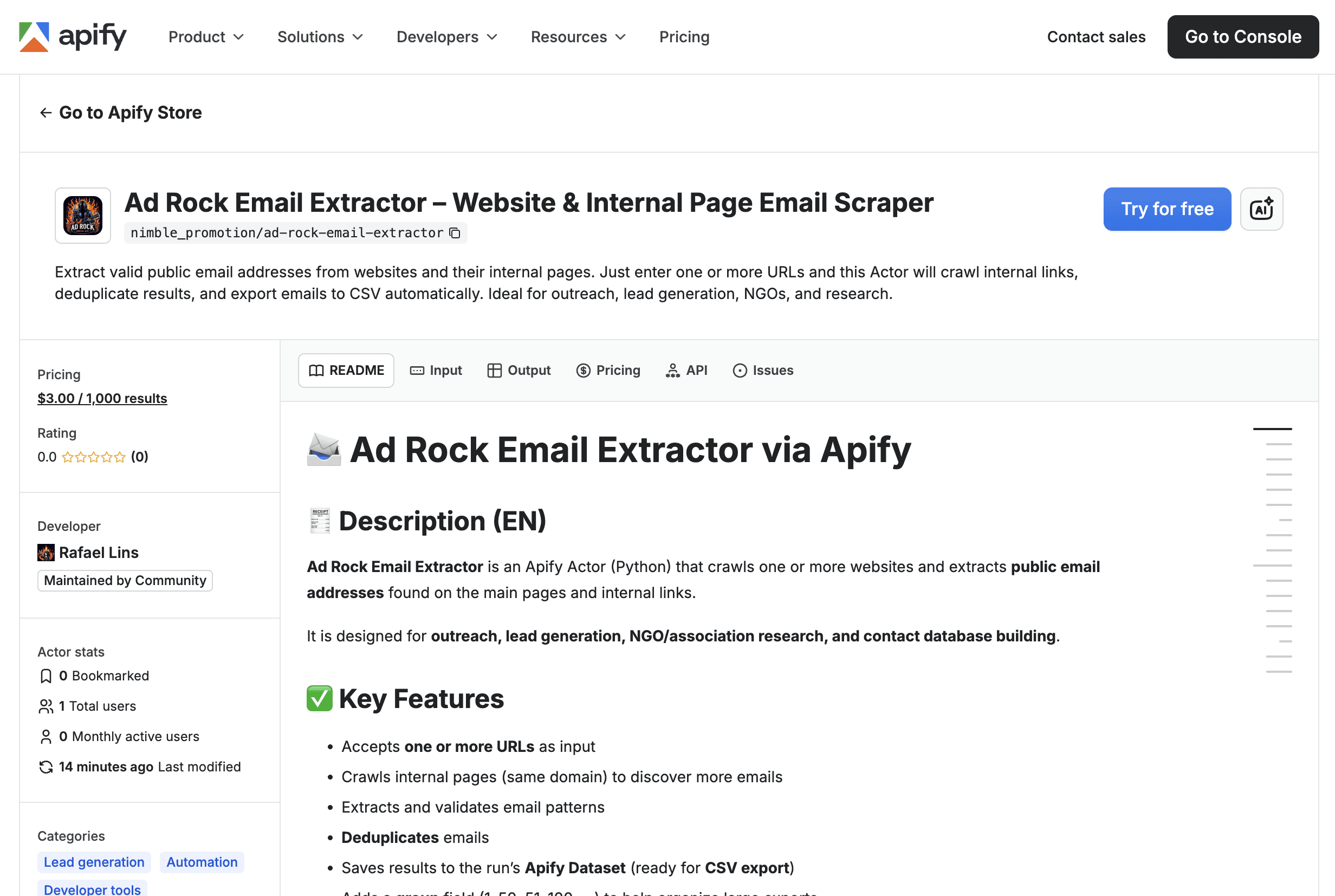

https://apify.com/nimble_promotion/ad-rock-email-extractor

Como funciona o Ad Rock Email Extractor no Apify

Você informa uma ou mais URLs

O Actor acessa o site principal

Identifica links internos (mesmo domínio)

Varre cada página em busca de e-mails públicos

Deduplica os resultados

Salva tudo em um Dataset pronto para exportação

Cada resultado segue este formato:

O campo group facilita a organização de grandes volumes de dados durante a exportação.

Quando usar script local vs Actor no Apify

Use script em Python quando:

Você está aprendendo scraping

Precisa de controle total do código

O volume é pequeno

O projeto é experimental

Use o Actor no Apify quando:

Precisa de escala

Quer exportação automática

Usuários não técnicos vão operar

O projeto envolve prospecção, ONGs, pesquisa ou times

Você quer reduzir custo operacional

Essa separação deixa o projeto tecnicamente mais maduro e comercialmente viável.

Casos de uso comuns

Prospecção B2B

Mapeamento de ONGs e associações

Pesquisa acadêmica

Construção de bases institucionais

Inteligência de mercado

Auditorias de presença digital

Sempre respeitando dados publicamente disponíveis.

Considerações finais

Automatizar a extração de e-mails não é apenas uma questão técnica — é uma decisão estratégica.

O que começou como um script em Python evoluiu para uma ferramenta robusta, escalável e pronta para produção.

Se você precisa ir além do código e ganhar velocidade, o Actor no Apify é o próximo passo natural.

Experimente agora:

👉 https://apify.com/nimble_promotion/ad-rock-email-extractor

Go back